Nach einer Reihe von Klagen und Kritik, weil es angeblich nicht gelungen ist, seine minderjährigen Benutzer vor Schaden zu schützen, gab das Startup Character AI, das es Benutzern ermöglicht, verschiedene KI-Charaktere zu erstellen und mit ihnen über Anrufe und Texte zu sprechen, am Dienstag bekannt, dass es eine neue Reihe von elterlichen Aufsichtswerkzeugen einführt, um die Sicherheit seiner jugendlichen Benutzer zu erhöhen.

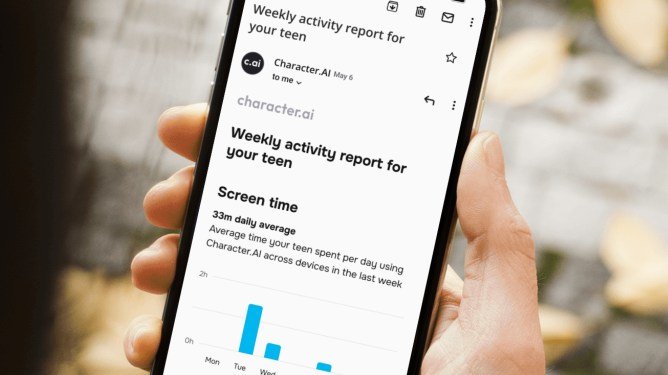

Character AI wird nun den Erziehungsberechtigten und Eltern eine Zusammenfassung der Aktivitäten ihrer Teenager auf der App per wöchentlicher E-Mail geben. Die E-Mail soll angeblich die durchschnittliche Zeit zeigen, die ein Kind auf der App und im Web verbringt, die Zeit, die es mit jedem Charakter spricht, und die Top-Charaktere, mit denen es in der Woche interagiert hat.

Das Startup sagt, dass diese Daten Eltern Einblicke in die Engagementgewohnheiten ihrer Teenager auf der Plattform geben sollen. Es wurde spezifiziert, dass Eltern keinen direkten Zugriff auf die Chats selbst erhalten.

Nach den Klagen hat das Startup im vergangenen Jahr Sicherheitsmaßnahmen wie ein spezielles Modell für Benutzer unter 18 Jahren, Benachrichtigungen über verbrachte Zeit und Haftungsausschlüsse hinzugefügt, um Benutzer daran zu erinnern, dass sie mit KI-gesteuerten Charakteren chatten. Das Unternehmen hat auch sensiblen Inhalt für die Ein- und Ausgabe blockiert, indem es neue Klassifizierungen für Jugendliche erstellt hat.

Zu Beginn dieses Jahres reichte das Startup einen Antrag auf Abweisung einer Klage ein, die behauptete, das Unternehmen habe an einem Teenager-Selbstmord mitgewirkt.